Slow Down ⑤ 상승곡선

• 댓글 2개 보기반론 3: “발전된 AI를 안전하게 만드는 방법을 찾기 위해서는 발전된 AI를 사용해봐야 한다"

이 반론은 AI를 개발하고 있는 사람들로부터 종종 듣게 된다. 그들 중에는 AI의 안전을 진지하게 생각하는 사람들도 포함된다.

그들은 이를 교통수단에 비유한다. 주요 이동 수단이 말과 마차였던 시절에 과연 모두가 자동차를 타게 될 미래의 안전규칙을 설계할 수 있었을까? 불가능했다는 게 그들의 주장이다. 모두가 자동차를 타는 세상이 어떤 모습일지 예상하기 힘들기 때문이다. 이와 마찬가지로 발전된 AI를 안전하게 만들기 위해서는 발전된 AI에 더 접근해야 한다는 얘기다.

하지만 여기에 동의하지 않는 연구자들도 있다. 말과 마차를 타던 사람들이 미래를 완벽하게 상상해내지는 못해도 도움이 될 만한 아이디어는 도출할 수 있었을 거라는 게 이들의 생각이다. 오픈AI에서 안전과 관련된 연구를 하는 로지 캠벨(Rosie Campbell)은 2018년의 인터뷰에서 이렇게 설명한다. "당시 사람들도 안전벨트나 자동차 전용 도로, 진행 방향에 따른 도로 사용, 차량이 많은 사거리에서 회전방향을 알려주는 방법 같은 걸 생각해내는 건 가능했을 거다."

더 중요한 건, 지금은 2023년이고, 우리는 벌써 상당히 발전된 AI를 갖고 있다는 사실이다. 우리가 지금 사용하고 있는 AI는 말과 마차 수준이 아니며, 마차와 테슬라 사이 어딘가에 있다. 아제야 코트라는 "10년 전이라면 (교통수단의 비유에) 좀 더 수긍했을 것 같다. 그 당시만 해도 지금 우리가 대용량 언어모델(LLM)에서 볼 수 있는 것과 같은 유연하고, 흥미롭고, 특이한 범용 AI는 어림도 없었기 때문"이라고 말한다. 그레이스도 동의한다. "우리가 생각해야 할 게 바닥난 게 아니지 않은가. 이 AI 모델에서 무슨 일이 일어나고 있는지 연구해야 할 것들이 산적해 있다."

현재 우리가 사용하는 AI 시스템은 그걸 만든 전문가들에게도 안에서 일어나는 일을 알기 힘든 블랙박스와 같은 존재다. 따라서 지금보다 더 알기 힘든 또 다른 블랙박스를 만들기 전에 현재 가진 블랙박스가 어떻게 작동하는지 확인해봐야 하지 않을까?

상승곡선을 평평하게 하는 법

"사람들은 세상을 바꿀 AI가 언제 등장하느냐고 종종 묻지만, 그런 AI가 얼마나 빠르게, 얼마나 갑작스럽게 일어날 것인지도 물어야 한다고 생각한다"라는 게 코트라의 생각이다.

세상을 완전히 바꿀 AI, 그러니까 모든 인간의 일을 모두 자동화해서 과학과 테크놀로지, 경제를 송두리째 바꿔놓는 시점이 앞으로 20년 남았다고 생각해 보자. 그 시점까지 도달하는 더 나은 방법과 더 나쁜 방법이 있다. 세 개의 AI 발전 시나리오는 다음과 같다.

- 지금부터 시작해서 앞으로 2년 동안 엄청난 발전을 한다.

- 지금부터 모든 AI 향상 작업을 일시 중지하고 18년 후에 재개한 후 2년 동안 엄청난 발전을 한다.

- 앞으로 20년 동안 점진적으로 AI 기술을 개선한다.

첫 번째는 우리가 이제까지 논의했던 이유들 때문에 두려운 시나리오다. 두 번째 시나리오 역시 무섭다. 앞으로 AI 연구를 멈춘다고 해도 기반이 되는 컴퓨팅 파워는 발전을 멈추지 않을 것이기 때문에 18년 후에 연구를 재개하는 하는 순간, 지금보다 더 빠른 발전을 하게 될 것이라 그렇다. 그렇다면 남은 옵션은 뭘까?

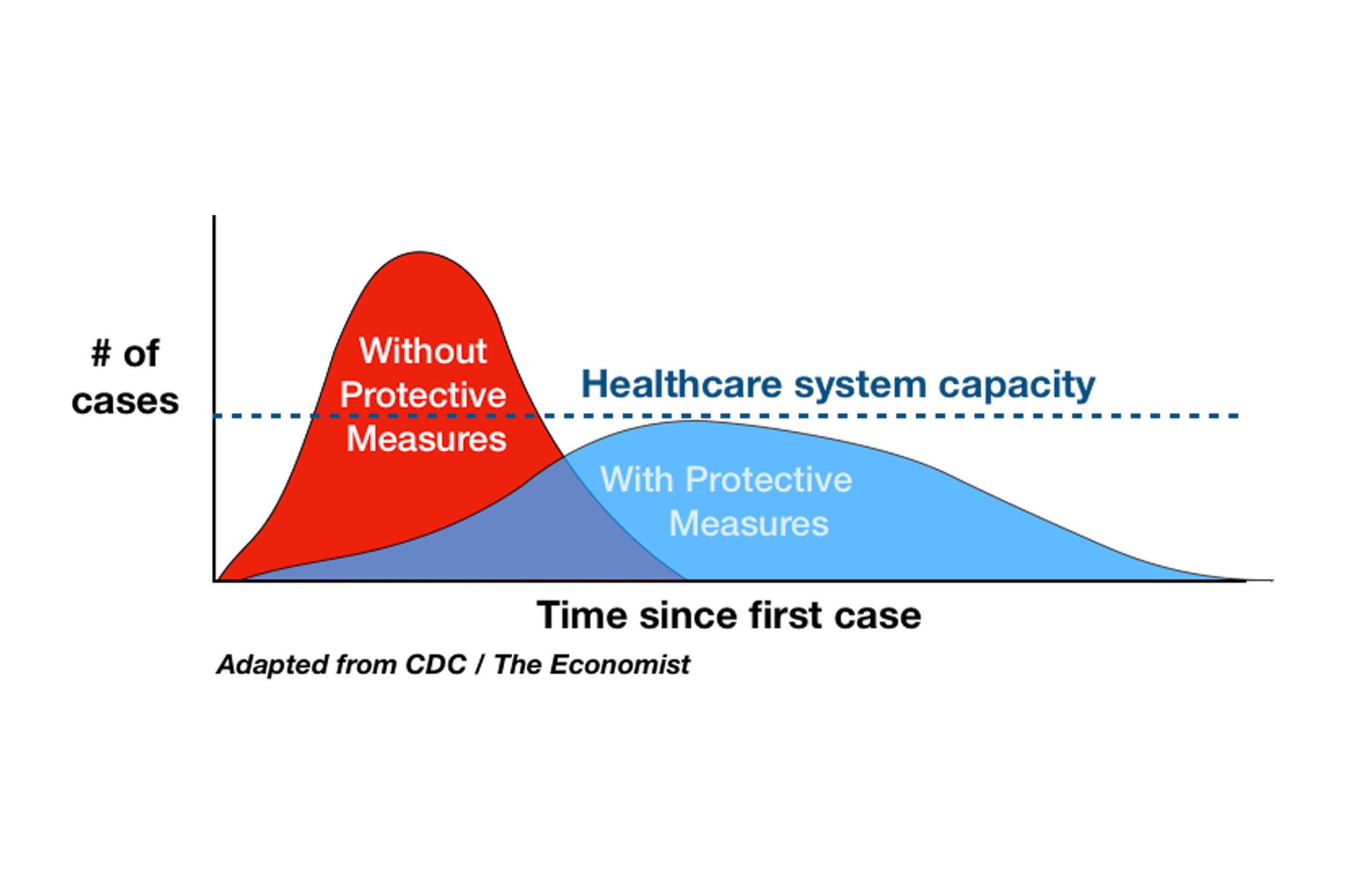

코트라는 "점진적인 개선이 더 나은 비전"이라고 말한다. 그는 이를 코로나 팬데믹 초기에 우리가 들었던 "상승 곡선을 평평하게 만들자(Flatten the curve)"라는 표현으로 설명한다. 감염자 격리를 통해 바이러스가 퍼지는 속도를 줄여서 병원들의 수용 능력을 넘지 않게 했던 것처럼, AI와 관련한 안전책에 투자하면 AI의 발전 속도를 줄이고 사회가 수용할 수 있는 능력을 넘는 가파른 곡선이 만들어지는 것을 막을 수 있다는 얘기다.

제프리 딩은 단기적으로 AI의 발전 속도를 줄이는 것이 모두에 이익이라고 설명하면서, 여기에는 수익을 내게 될 사람들도 포함된다고 한다. "AI 안전에 투자하는 것은 테크 기업이나 정책 입안자, 그리고 자기 나라가 AI로 이득을 누렸으면 하는 사람들 모두에게 좋다. 그렇게 할 경우 대중의 반발(backlash)이 줄어들고, 기술의 장기적, 지속적 발전을 추구할 수 있기 때문이다. 그렇기 때문에 나는 AI 안전에 대한 투자를 '장기적으로 지속가능한 경제적 이익'이라는 프레임으로 설명한다." 쉬운 말로 하면, 지금 적당한 수익을 내면서 AI를 서서히 개선해서 새로운 기술을 계속해서 선보이고 꾸준히 이윤을 내는 것이, 남들이 눈살을 찌푸릴 만큼의 돈을 아주 단기간에 벌어들이는 과정에서 사고를 내고 그 결과 대중의 분노를 사서 사업을 완전히 포기하게 되는 것보다 더 나은 방법이라는 거다.

하지만 테크업계가 그걸 받아들일까? 그건 부분적으로 우리, 즉 대중이 챗GPT나 빙, 혹은 그다음에 등장할 새롭고 신기한 AI에 어떻게 반응하느냐에 달렸다. 새로운 기술에 매혹되는 건 쉽다. 이런 기술들이 우리 눈에는 마술처럼 보인다. 명령어를 넣기만 하면 신탁이 내려오니 눈이 휘둥그레지는 건 당연하다. 하지만 지금의 발전 속도로는 우리는 정신을 못 차리는 사이에 아무도 원치 않는 미래에 도착할지 모른다.

원문은 여기에서 읽을 수 있습니다.

무료 콘텐츠의 수

테크와 사회, 문화를 보는 새로운 시각을 찾아냅니다.

유료 구독자가 되시면 모든 글을 빠짐없이 읽으실 수 있어요!

Powered by Bluedot, Partner of Mediasphere